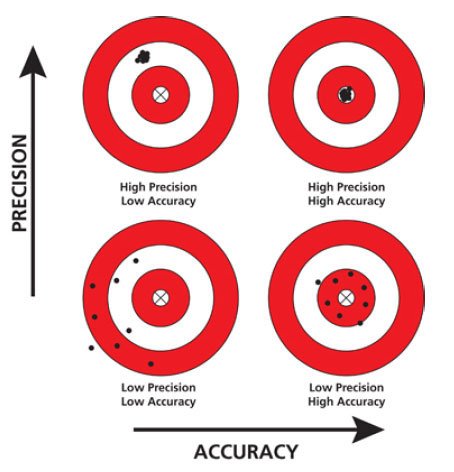

En règle générale, le terme «précision» fait référence à une partie systématique de l'erreur, tandis que «précision» fait référence à la partie aléatoire:

Réduire la plage ADC (en abaissant la tension de référence) augmentera la résolution et réduira le bruit de quantification (ce qui n'est pas systématique *), améliorant ainsi la précision absolue . Cependant, cette amélioration ne sera visible que si le bruit de quantification est dominant: si un autre type de bruit aléatoire significatif (par exemple du CA sur la ligne d'alimentation) est présent, l'amélioration de la précision ne sera pas perceptible.

La précision (ou justesse) peut également s'améliorer en fonction des propriétés internes de l'ADC. Les erreurs de non-linéarité et de gain sont (généralement) proportionnelles à la tension de référence, de sorte que ces erreurs absolues seront généralement réduites, tandis que l'erreur de décalage peut souvent ne pas changer. Le changement global de précision dépendra à nouveau de laquelle de ces erreurs est dominante.

Selon Wikipédia, la "précision" peut être utilisée pour décrire une combinaison d'erreurs aléatoires et systématiques, donc lorsque la précision et l'exactitude sont améliorées, il n'est pas faux de dire que la mesure est meilleure précision.

(*) - l'erreur de quantification dépend en fait du signal, mais c'est une hypothèse très utile nécessaire pour le modèle de bruit additif, qui est automatiquement valable lorsque cette erreur est relativement petite. Lorsque le bruit de quantification est important, un bruit aléatoire artificiel ( dither) est souvent appliqué pour faire fonctionner le modèle de bruit additif.